Контент-фильтр: принцип работы, преимущества и риски использования

В интернете далеко не все содержимое безопасно: множество сайтов распространяют вредоносное ПО, нарушают закон и собирают данные пользователей без их согласия. Посещение таких ресурсов может привести к заражению устройств или утечке конфиденциальной информации.

Предотвратить эти риски позволяет контентная фильтрация — технология, которая выявляет потенциально опасный или нежелательный контент и ограничивает к нему доступ. В статье рассмотрим, как она работает и какие инструменты для этого применяются.

Что такое контент-фильтр

Контент-фильтр — это технологическое решение, предназначенное для анализа, отбора и ограничения доступа к цифровым данным на основе заранее заданных критериев. Его главная задача — предотвращать взаимодействие пользователей с материалами, которые могут быть вредоносными, незаконными или нарушать установленные нормы.

Основные цели контент-фильтрации включают:

- Защиту от угроз, таких как вирусы, фишинг, дезинформация, экстремистские призывы или контент сексуального характера.

- Соблюдение законодательства, например, блокировка материалов, которые запрещены судом или нарушают авторские права.

- Обеспечение соответствия внутренним правилам — будь то корпоративная политика безопасности или школьные нормы поведения в сети.

Уровни фильтрации контента

В зависимости от контекста применения выделяют три основных уровня контентной фильтрации:

- На уровне сети. Реализуется интернет-провайдерами или государственными органами. Это может быть блокировка сайтов по решению Роскомнадзора или фильтрация трафика в рамках национальных систем цензуры (например, «Великий китайский файрвол» в КНР).

- На уровне платформ. Используется социальными сетями, видеохостингами, форумами и другими онлайн-сервисами для модерации пользовательского контента. Такие фильтры сканируют публикации на предмет спама, ненависти, насилия или нарушения авторских прав.

- На уровне пользователя. Применяется индивидуально через антивирусные программы, браузерные расширения или функции родительского контроля. Позволяет ограничить доступ к нежелательному контенту внутри конкретного устройства или учетной записи.

Эти уровни можно реализовать как по отдельности, так и в комбинации, чтобы обеспечить комплексную защиту в цифровом пространстве.

Основные типы фильтруемого контента

Современные системы контент-фильтрации нацелены на выявление и блокировку широкого спектра материалов, которые могут причинить вред пользователям, нарушить закон или подорвать доверие к цифровой среде. Условно такой контент можно разделить на несколько категорий.

Незаконный контент — материалы, запрещенные законодательством большинства стран. К ним относятся:

- террористическая пропаганда и инструкции по изготовлению оружия или взрывчатых веществ;

- детская порнография и иная эксплуатация несовершеннолетних;

- прямые призывы к насилию, экстремизму или дискриминации по признакам расы, пола, религии и т. д.

Вредоносный контент — не обязательно незаконный, но несущий прямую угрозу безопасности устройств или персональных данных пользователей:

- фишинговые страницы, имитирующие легитимные сервисы (банки, соцсети);

- сайты и сообщения, которые используются для распространения мошеннических схем;

- ссылки на загрузку вредоносного ПО — троянов, шпионских программ, ransomware.

Неприемлемый или нежелательный контент — не всегда подпадает под юридические запреты, но нарушает правила сообществ или корпоративные стандарты:

- троллинг и оскорбительные комментарии;

- хейт-спич (выражения ненависти в адрес определенных групп);

- спам и навязчивая реклама;

- дезинформация, включая фейковые новости и манипулятивные нарративы;

- синтетический медиаконтент, такой как дипфейки, созданные с целью введения в заблуждение.

Отдельную категорию составляет контент, который нарушает авторские права. С.да входит несанкционированное размещение фильмов, музыки, программного обеспечения, статей и других защищенных материалов. Платформы часто фильтруют такие публикации по запросу правообладателей в рамках систем вроде Content ID (YouTube) или автоматических технологий обнаружения нарушений.

Технологии контентной фильтрации

Современные системы контент-фильтрации опираются на разнообразные технологические подходы — от простых статических правил до сложных решений с использованием искусственного интеллекта. Выбор метода зависит от типа контента, требуемой точности и контекста использования.

Правила и списки

Один из самых базовых инструментов фильтрации — использование черных и белых списков.

- Черный список (blacklist) содержит запрещенные домены, URL, IP-адреса или хеши контента, к которым необходимо заблокировать доступ.

- Белый список (whitelist), напротив, разрешает взаимодействие только с заранее одобренными ресурсами. Такой подход часто применяется в корпоративных и образовательных сетях, где требуется строгий контроль трафика.

Ключевые слова и регулярные выражения

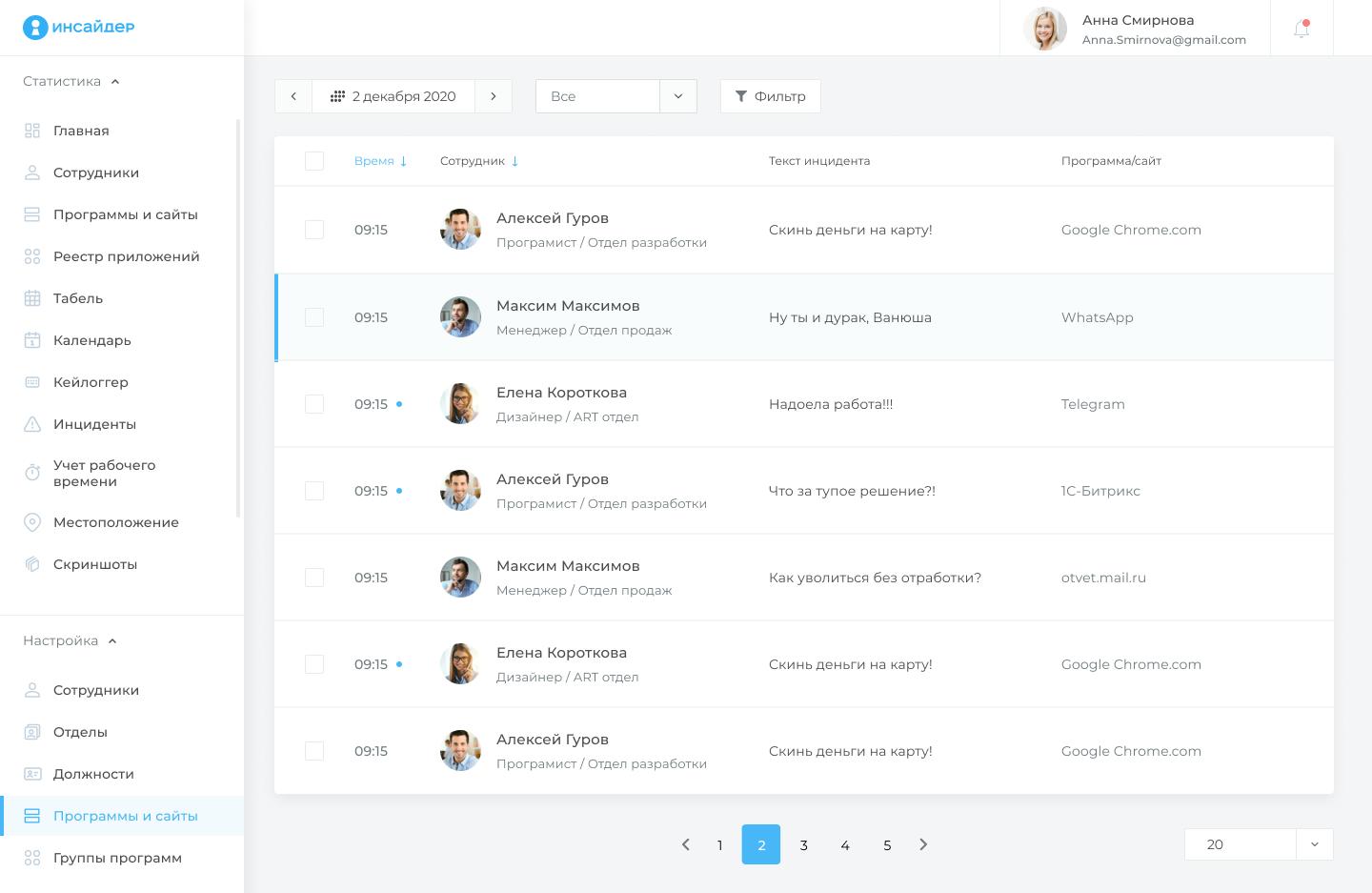

Эти методы позволяют сканировать текст на наличие потенциально опасных или нежелательных фраз — например, угроз, оскорблений или спам-триггеров. На практике они широко применяются в корпоративных программах контроля и системах мониторинга.

Например, в «ИНСАЙДЕРе» предусмотрен кейлоггер, который в реальном времени фиксирует вводимый пользователем текст и анализирует его на соответствие заданным спискам ключевых слов и регулярных выражений.

Это позволяет организациям выявлять потенциально рискованное поведение — от утечки конфиденциальной информации до проявлений агрессии или нарушения внутренних политик и регламентов.

Хеш-фильтрация

Для точного сопоставления уже известного вредоносного контента применяется хеш-фильтрация. Яркий пример — технология PhotoDNA от Microsoft, предназначенная для идентификации изображений детской эксплуатации по уникальным цифровым «отпечаткам», устойчивым к изменениям формата, обрезке или незначительным искажениям.

Машинное обучение и ИИ

С развитием искусственного интеллекта все чаще используются адаптивные модели, способные анализировать контент в контексте:

- NLP (Natural Language Processing) — обрабатывает текст, распознает сарказм, хейт-спич, дезинформацию и другие тонкие формы нарушений.

- Компьютерное зрение анализирует изображения и видео: выявляет насилие, обнаженную натуру, запрещенную символику и другие визуальные признаки нарушений.

- Нейросетевые архитектуры. Среди популярных — BERT (Bidirectional Encoder Representations from Transformers) для глубокого понимания семантики текста и YOLO (You Only Look Once) для быстрого и точного обнаружения объектов на изображениях.

Гибридные системы

На практике наиболее эффективными оказываются гибридные системы, которые сочетают жесткие правила (например, черные списки или ключевые слова) с адаптивными ИИ-алгоритмами. Такой подход повышает как точность фильтрации, так и устойчивость к попыткам обхода.

Модерация с участием человека

Несмотря на достижения автоматизации, полностью исключить ложные срабатывания или пропуски невозможно. Поэтому многие платформы используют подход human-in-the-loop, при котором спорные, неоднозначные или потенциально важные случаи передаются на проверку модераторам-людям. Такой человеко-машинный симбиоз помогает сохранять баланс между масштабируемостью автоматических систем и справедливостью, основанной на человеческом суждении.

Применение контент-фильтрации

Контент-фильтрация используется на разных уровнях — от государственных структур до отдельных пользователей. Ее применение варьируется в зависимости от целей: это может быть как защита личного устройства, так и национальной безопасности.

Государственный уровень

На государственном уровне фильтрация часто служит инструментом регулирования онлайн-пространства. В некоторых странах она принимает форму интернет-цензуры, как, например, в Китае, где «Золотой щит» блокирует доступ к зарубежным сайтам, соцсетям и СМИ, не соответствующим официальной политике.

В других юрисдикциях фильтрация носит законодательный характер. Так, Европейский союз через Цифровой сервисный акт (DSA) обязывает крупные платформы активно выявлять и удалять незаконный контент, а в США действуют законы вроде Children’s Online Privacy Protection Act (COPPA), который требует защиты детей от неподходящего контента и сбора их данных без согласия родителей.

Корпоративный уровень

Компании используют фильтрацию для соблюдения норм, защиты бренда и обеспечения безопасной среды для пользователей.

- Социальные сети применяют сложные ИИ-системы для модерации миллиардов публикаций ежедневно и блокировки спама, хейт-спича, дезинформации и нарушений авторских прав.

- Поисковые системы и рекламные платформы фильтруют результаты и объявления, чтобы исключить мошеннические, вредоносные или иные материалы, которые нарушают политику.

- Облачные сервисы и хостинги внедряют фильтрацию на уровне инфраструктуры, чтобы предотвратить размещение запрещенного контента на своих серверах и соответствовать международным требованиям.

Индивидуальный уровень

На уровне конечного пользователя контент-фильтрация помогает персонализировать безопасность в сети.

- Родительский контроль в операционных системах, роутерах и специализированных приложениях позволяет ограничить доступ детей к нежелательным сайтам или контенту для взрослых.

- Антивирусные программы и браузерные расширения сканируют веб-трафик в реальном времени, блокируют фишинг, трекеры, вредоносные скрипты и нежелательную рекламу.

Таким образом, контент-фильтрация охватывает все цифровое пространство — от глобальной политики до личного устройства, и обеспечивает многоуровневую защиту.

Преимущества фильтрации контента

Контент-фильтр — не просто технический инструмент, а важный аспект кибергигиены, применение которого обеспечивает:

- Повышение безопасности пользователей. Одно из главных достоинств фильтрации. Блокировка вредоносных сайтов, фишинговых страниц и контента, связанного с эксплуатацией или насилием, помогает защитить личные данные, устройства и психологическое благополучие, особенно у детей и других уязвимых групп.

- Снижение распространения дезинформации и вредоносного контента. Фильтры ограничивают охват фейковых новостей, мошеннических схем и экстремистских материалов, что особенно важно в условиях кризисов, выборов или массовых событий, когда ложные сведения могут иметь реальные последствия.

- Соответствие правовым нормам и снижение юридических рисков. Критически важный аспект для бизнеса и государственных структур. Автоматическая фильтрация помогает платформам соблюдать требования законодательства, избегать штрафов, блокировок и репутационных рисков.

- Улучшение пользовательского опыта. Удаление спама, троллинга, навязчивой рекламы и оскорбительных комментариев делает общение в сети более комфортным, конструктивным и безопасным, что повышает вовлеченность и лояльность аудитории.

Возможные проблемы и критика

Несмотря на очевидные преимущества, контент-фильтрация сталкивается с серьезной критикой со стороны правозащитников, исследователей и пользователей. Многие ее недостатки связаны не столько с технологиями, сколько с трудностями интерпретации контекста, норм и ценностей в глобальном цифровом пространстве.

- Ложные срабатывания (overblocking) — одна из самых частых проблем. Автоматические системы нередко блокируют или удаляют легитимный контент: образовательные материалы, сатиру, документальные свидетельства насилия или даже посты жертв преступлений. Такие ошибки могут подавлять свободное выражение мнений под видом модерации.

- Недостаточная фильтрация (underblocking) — обратная сторона той же медали. Вредоносный или незаконный контент все еще проникает через защитные барьеры, особенно если он замаскирован, использует сленг, иронию или новые форматы (например, дипфейки). Это подрывает доверие к системам фильтрации и оставляет пользователей уязвимыми.

- Предвзятость алгоритмов — еще один системный вызов. ИИ-модели обучаются на исторических данных, которые могут содержать культурные, гендерные или языковые предубеждения. В результате фильтры чаще ошибаются в отношении контента на «меньшинственных» языках, критики власти или выражений, характерных для определенных сообществ.

Отсутствие прозрачности усугубляет эти проблемы. Большинство алгоритмов работают как «черные ящики»: пользователи не знают, почему их контент удален, а разработчики редко раскрывают логику принятия решений. Это затрудняет обжалование ошибок и снижает подотчетность платформ.

Все это поднимает тревожные вопросы о цензуре и свободе слова. Когда частные компании или государства определяют, какой контент «допустим», возникает риск злоупотребления властью — особенно в странах с авторитарными режимами или при отсутствии независимых надзорных органов.

Кроме того, перед обществом стоит глубокая этическая дилемма: кто имеет право решать, что считать «плохим» или «хорошим» контентом? Культурные, религиозные и политические нормы сильно различаются, и универсальных критериев не существует. Без открытого диалога и четких правовых рамок контент-фильтрация рискует стать инструментом контроля, а не защиты.

Правовые и регуляторные аспекты

Контент-фильтрация все чаще становится не просто техническим выбором, а юридической обязанностью. По мере роста влияния цифровых платформ государства и международные организации разрабатывают нормативные акты, которые обязывают компании контролировать размещаемый контент.

Среди ключевых регуляторных инициатив в РФ:

- Федеральный закон № 152-ФЗ «О персональных данных». Обязывает операторов защищать персональную информацию пользователей и ограничивать ее распространение без согласия, тем самым косвенно стимулирует внедрение фильтров для предотвращения утечек или публикации ПДн в открытом доступе.

- Федеральный закон № 398-ФЗ («антифейковый» закон) и смежные нормы, которые запрещают распространение недостоверной общественно значимой информации. Требуют от платформ оперативного выявления и блокировки контента, признанного дезинформирующим.

- Положения о «суверенном интернете» (ФЗ № 90-ФЗ и № 191-ФЗ). Предоставляют Роскомнадзору полномочия по централизованной блокировке ресурсов и требуют от провайдеров и владельцев информационных систем внедрения технических средств фильтрации трафика.

- Требования по борьбе с экстремизмом и детской порнографией (ст. 15.1 и 15.2 КоАП РФ, ФЗ № 436-ФЗ). В соответствии с этими нормативными актами операторы обязаны использовать реестры запрещенных сайтов и автоматически блокировать доступ к соответствующему контенту.

Эти нормы формируют правовую основу для обязательной контент-фильтрации на территории России и напрямую влияют на архитектуру цифровых сервисов. Что касается других государств, там действуют свои национальные законы. Например, в Китае жесткая цензура регулируется комплексом норм, включая требования к локализации данных и обязательной модерации. В Индии, Бразилии и других странах разрабатываются собственные правила, которые часто сочетают требования к фильтрации с ограничениями на шифрование и анонимность.

Особое внимание уделяется вопросу ответственности платформ за контент пользователей. Ранее многие юрисдикции освобождали цифровые системы от ответственности за пользовательские публикации. Однако в последние годы этот принцип пересматривается: регуляторы все чаще требуют от компаний проактивного контроля, особенно в отношении террористического, детского или дезинформационного контента.

При этом международные различия в подходах к регулированию создают серьезные вызовы. То, что считается незаконным в одной стране (например, критика власти), может быть защищено как свобода слова в другой. Это ставит глобальные платформы перед дилеммой: либо применять единые правила, рискуя нарушить местное законодательство, либо адаптироваться к каждому рынку, что усложняет управление и повышает издержки.

Будущее контент-фильтрации

По мере роста сложности цифрового контента и эволюции угроз системы фильтрации также стремительно развиваются. В ближайшие годы ожидается переход от узкоспециализированных решений к более гибким, интеллектуальным и этически осознанным подходам.

Развитие мультимодальных ИИ-систем

Этот тренд станет ключевым. Современные модели все чаще способны одновременно анализировать текст, изображения, аудио и видео в едином контексте — например, распознавать сарказм в меме или выявлять дезинформацию в коротком ролике. Такие системы (вроде GPT-V, Llama Vision или специализированных моделей от Google и Meta*) позволят значительно повысить точность фильтрации и снизить количество ложных срабатываний.

*Признана экстремистской организацией, чья деятельность запрещена на территории РФ.

Персонализированная фильтрация

Вместо универсальных правил платформы начнут предлагать настраиваемые фильтры: пользователь сам сможет определить, какой контент считать нежелательным — будь то политические темы, жестокие сцены или реклама определенных категорий. Это повысит автономию, но потребует прозрачных и безопасных механизмов управления настройками.

Блокчейн и децентрализованные подходы

Станут альтернативой централизованной модерации. В децентрализованных соцсетях (например, на базе протоколов Lens или Farcaster) модерация может осуществляться сообществами через криптографически подтвержденные голосования или репутационные системы, что позволяет минимизировать риски цензуры со стороны единого оператора.

Этические стандарты и независимый аудит алгоритмов

Пользователи, регуляторы и исследователи требуют большей прозрачности: публикации метрик эффективности, тестирования на предвзятость, участия независимых экспертов в оценке систем. Возможны появление сертификаций «этичной модерации» и обязательных отчетов по DSA-типу в других юрисдикциях.

Однако развитие фильтрации неизбежно сопровождается попытками ее обхода. Технологии вроде стеганографии (сокрытие информации внутри изображений или аудио), сквозного шифрования, анонимайзеров и генеративных ИИ затрудняют автоматический контроль контента, что создает постоянную «гонку вооружений» между системами фильтрации и теми, кто стремится их обойти.

Заключение

Контент-фильтр — важный элемент цифровой экосистемы. В условиях постоянного увеличения объема контента, роста киберугроз и давления со стороны регуляторов фильтрация помогает защищать пользователей, соблюдать законы и поддерживать минимальные стандарты киберпорядка.

Однако ее внедрение сопряжено с серьезными вызовами. Главный из них — найти баланс между обеспечением безопасности и защитой свободы слова, эффективностью автоматической модерации и справедливостью в отношении разнообразных культур, языков и точек зрения. Ни одна технология сама по себе не способна решить эти дилеммы.

Поэтому будущее контент-фильтрации зависит не только от алгоритмов, но и от междисциплинарного подхода, в котором тесно взаимодействуют технологии, право, этика и социология. Только совместными усилиями инженеров, юристов, правозащитников, исследователей и самих пользователей можно создать системы, которые будут не просто блокировать «плохое», а способствовать развитию более безопасного, справедливого и открытого цифрового мира.

Часто задаваемые вопросы о фильтрации контента

Что такое контент-фильтр простыми словами?

Контент-фильтр — это программное или аппаратное решение, которое автоматически анализирует цифровой контент (текст, изображения, видео, ссылки) и ограничивает доступ к материалам, признанным вредоносными, незаконными или нежелательными.

Для чего нужна фильтрация контента?

Фильтрация помогает:

- защищать пользователей от мошенничества, вирусов и опасного контента;

- соблюдать законы (например, о защите детей или авторском праве);

- поддерживать порядок на платформах (борьба со спамом, троллингом, хейт-спичем);

- обеспечивать безопасность в корпоративных и учебных сетях.

Какие бывают типы контент-фильтров?

В зависимости от уровня фильтрации выделяют три типа фильтров, которые анализируют контент:

- на уровне сети (провайдеры, государственные системы);

- на уровне платформы (социальные сети, видеохостинги, форумы);

- на уровне устройства (родительский контроль, антивирусы, браузерные расширения).

Как работают контент-фильтры?

Для фильтрации контента используют разные технологии:

- черные/белые списки сайтов;

- поиск по ключевым словам и регулярным выражениям;

- хеш-сопоставление (например, PhotoDNA для изображений);

- искусственный интеллект (NLP для текста, компьютерное зрение для видео);

- гибридные системы с участием человека (модераторов).

Может ли контент-фильтр ошибаться?

Да. Возможны два типа ошибок:

- Overblocking, или ложное срабатывание — легитимный контент блокируется (например, новость о теракте принимается за пропаганду насилия);

- Underblocking, или недостаточная фильтрация — вредоносный контент проходит фильтр (например, из-за использования сленга или шифрования).

Фильтрация контента является ограничением свободы слова?

Это один из главных этических споров. Фильтрация может защищать от вреда, но при отсутствии прозрачности и механизмов обжалования превращается в форму цензуры. Важно, чтобы правила модерации были четкими и подотчетными.

Обязаны ли компании использовать контент-фильтры?

Во многих странах — да. Например, в ЕС по Digital Services Act (DSA) крупные платформы обязаны оперативно удалять незаконный контент. В России действуют законы о суверенном интернете, защите детей и борьбе с фейками, которые требуют фильтрации.

Можно ли обойти контент-фильтр?

Теоретически да. Пользователи могут использовать:

- замену символов (@ вместо буквы «а» и т.д.);

- шифрование и анонимайзеры;

- стеганографию (скрытие информации в изображениях);

- генеративные ИИ для переформулировки запрещенных фраз.

Однако современные контент-фильтры уже способны распознавать многие из этих уловок. Например, продвинутые системы на основе ИИ учитывают не только точное написание слова, но и его фонетические, визуальные и семантические варианты.

Используются ли контент-фильтры в корпоративной среде?

Да, причем довольно активно. Компании внедряют фильтрацию для:

- предотвращения утечек данных;

- блокировки нерабочих и подозрительных сайтов;

- соблюдения политик информационной безопасности.

Как пользователь может повлиять на работу контент-фильтра?

Многие цифровые платформы позволяют:

- пожаловаться на ошибочную модерацию;

- настроить персональные фильтры (например, скрыть определенные темы);

- использовать расширения для дополнительной защиты или, наоборот, для отключения чрезмерной фильтрации.

Кроме того, пользователи могут участвовать в формировании политик модерации — например, через общественные советы, опросы, публичные консультации или обратную связь с разработчиками.